Infernet / Tay les agents conversationnels sont des cons

Internet peut être défini comme un couplage : couplage entre les réseaux de télécommunication et l’hypertexte, document ou ensemble de documents informatiques permettant de passer d’une information à une autre par un système de liens. L’hypertexte est le fruit de l’intelligence artificielle. Les moteurs de recherche sont le fruit de l’intelligence artificielle. La reconnaissance d’image et la reconnaissance vocale sont les fruits de l’intelligence artificielle. Enfin les « bots », logiciels conçus pour converser avec un utilisateur, sont les fruits de l’intelligence artificielle. À travers Internet, à travers notre usage des moteurs de recherche comme des réseaux sociaux, nous sommes en permanence en interaction avec les fruits de l’intelligence artificielle, au point que leur fréquentation a sans doute modifié en profondeur notre manière de voir, d’apprendre, de penser, de parler et d’agir.

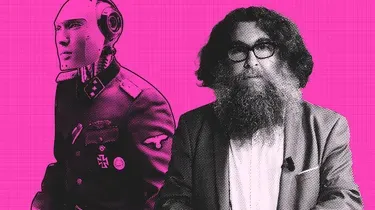

Crédits photo/illustration en haut de page :

(c) Adrien Colrat